Un très grand nombre de sites sources, dans des formats inconnus…

Le client a lui-même des opérateurs de trading, qui sont interessés pour recevoir ces signaux faibles, du fait qu’ils doivent anticiper à la baisse ou à la hausse les évolutions de leur portefeuille, et le cas échéant procéder à des arbitrages temps réel.

Le premier enjeu du projet était le volume de données à crawler, la multiplicité des sources. Avaient été sélectionné dès le départ 30.000 pages sur plus de 5.000 sites.

La disponibilité et la rapidité de capture de ces données, dans un créneau temps, permettant réellement d’interagir était le second enjeu, compte tenu du dynamisme des marchés financiers.

Artificial Intelligence Scoring

Le système global a été calibré pour se dimensionner automatiquement aux sources, à leur fréquence de rafraichissement, en ré-évaluant perpétuellement la pertinence et l’actualisation de cette classification.

Un système d’alerte a été mis en place pour surveiller les sources éventuellement mortes, et pour identifier les accélérations de fréquence d’actualisation, qui s’est avéré être plus efficace que ce que le client lui-même attendait. Afin d’adresser la problématique temps réel, et pour atteindre notre objectif de 5-10 minutes après production du signal, nous avons fait évoluer notre plateforme pour utiliser une technologie Big Data de répartition de tâches/processing quasiment illimitée.

Aussi bien au niveau de la collecte des données elle-même, que de l’utilisation massive d’API Intelligence Artificielle, cette démultiplication de notre capacité, nous a permis de répondre en terme d’effet financier sur le scoring positif/négatif des valeurs surveillées.

Les données finales étaient fournies au système d’information client en format JSON.

Avantages pour le client

- Le client avait enfin un service fournit à 100% par des API, bénéficiant d’un chargement continu

- L’Ontologie, la Taxonomie du client, ainsi que les statistiques associées, étaient enfin directement graphiquement gérable par les analystes fonctionnels

- Le client avait enfin un service fournit à 100% par des API, bénéficiant d’un chargement continu

- Infrastructure et opérating complet fournit par Scrapy Ninja

- Infrastructure à la demande, en scalabilié horizontale, avec une réduction des coût significative

- Intelligence Artificielle et analyse Deep Learning

- Le client a pu concentrer ses efforts sur l’analyse de données, sur la simulation et jeux d’historique Deep Learning sur le système de scoring

Sites Crawlés

Clients Heureux

Pages Crawlés / Jour

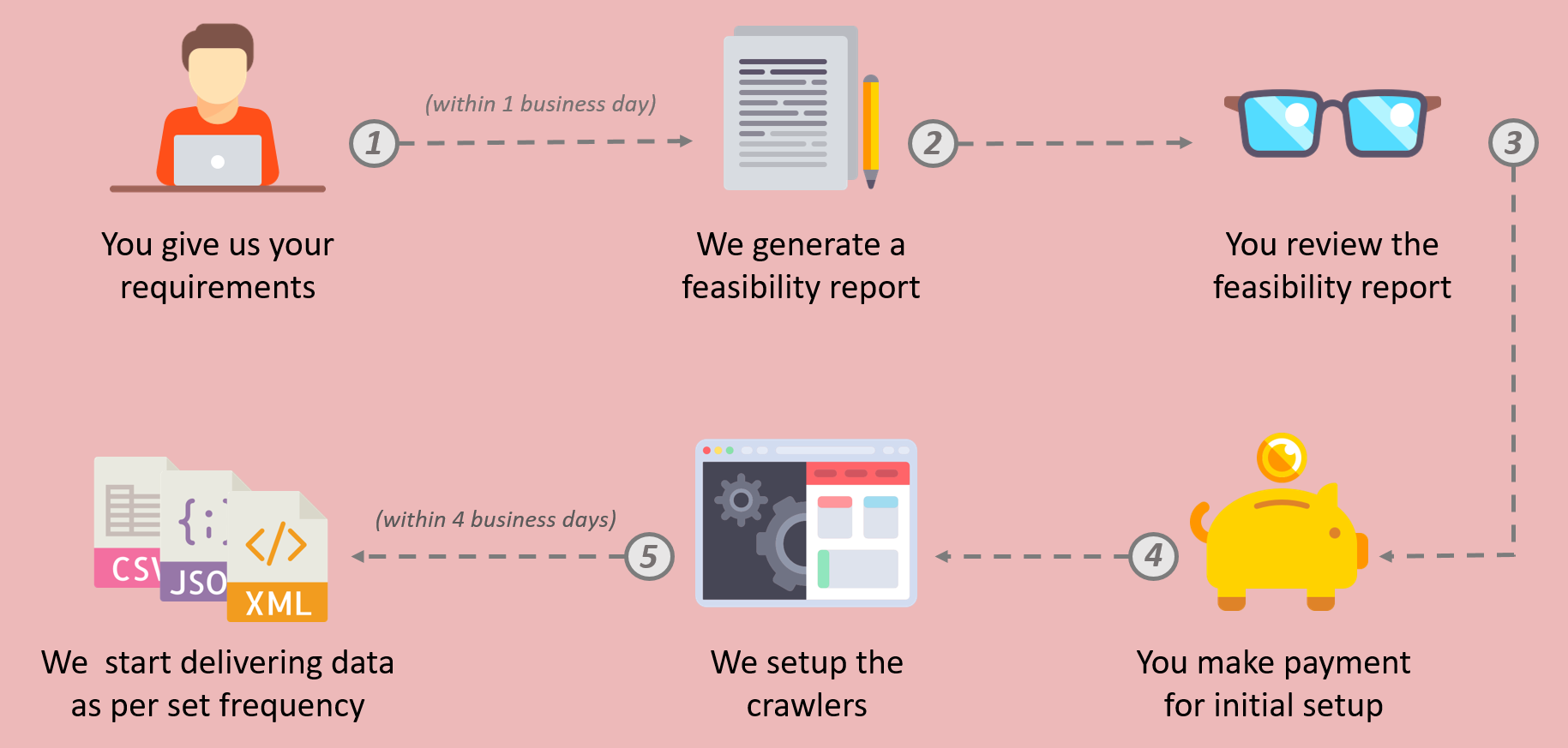

Depuis vos besoins spécifiques, obtenez un devis personnalisé

Quelles Données voulez-vous aujourd’hui ?

– Oui, c’est aussi simple que cela.